Preocupações com a “fábrica” baseada em dados que aumenta significativamente o número de alvos para ataques no território palestino

Publicado em 1º/12/2023 – 10h03

Por Harry Davies, Bethan McKernan e Dan Sabbagh – Jerusalém

The Guardian — Os militares de Israel não fizeram segredo da intensidade do seu bombardeamento da Faixa de Gaza. Nos primeiros dias da ofensiva, o chefe da sua força aérea falou de ataques aéreos implacáveis, “24 horas por dia”. As suas forças, disse ele, estavam apenas atacando alvos militares, mas acrescentou: “Não somos cirúrgicos”.

No entanto, tem sido dada relativamente pouca atenção aos métodos utilizados pelas Forças de Defesa de Israel (IDF) para selecionar alvos em Gaza e ao papel que a inteligência artificial tem desempenhado na sua campanha de bombardeio.

À medida que Israel retoma a sua ofensiva após um cessar-fogo de sete dias, aumentam as preocupações sobre a abordagem das FDI numa guerra contra o Hamas que, de acordo com o ministério da saúde na Faixa de Gaza administrada pelo Hamas, já matou mais de 15.000 pessoas no território.

A IDF há muito que aprimora a sua reputação de proeza técnica e já fez afirmações ousadas, mas não verificáveis, sobre o aproveitamento de novas tecnologias. Após a guerra de 11 dias em Gaza, em maio de 2021, as autoridades disseram que Israel travou a sua “primeira guerra de IA” utilizando aprendizagem automática e computação avançada.

A última guerra Israel-Hamas proporcionou uma oportunidade sem precedentes para as FDI utilizarem tais ferramentas num teatro de operações muito mais amplo e, em particular, para implantarem uma plataforma de criação de alvos de IA chamada “o Evangelho”, que acelerou significativamente uma guerra letal.

O Guardian pode revelar novos detalhes sobre o Evangelho e o seu papel central na guerra de Israel em Gaza, utilizando entrevistas com fontes de inteligência e declarações pouco notadas feitas pelas FDI e por funcionários reformados.

Este artigo também se baseia em testemunhos divulgados pela publicação israelense-palestina +972 Magazine e pelo canal de comunicação em hebraico Local Call, que entrevistaram diversas fontes atuais e antigas da comunidade de inteligência de Israel que têm conhecimento da plataforma do Evangelho.

Os seus comentários oferecem um vislumbre de uma unidade secreta de inteligência militar facilitada pela IA que está desempenhando um papel significativo na resposta de Israel ao massacre do Hamas no sul de Israel, em 7 de outubro.

A imagem lentamente emergente de como os militares de Israel aproveitam a IA surge num contexto de preocupações crescentes sobre os riscos que representam para os civis, à medida que militares avançados em todo o mundo expandem a utilização de sistemas automatizados complexos e opacos no campo de batalha.

“Outros estados estarão observando e aprendendo”, disse um ex-oficial de segurança da Casa Branca, familiarizado com o uso de sistemas autônomos pelos militares dos EUA.

A guerra Israel-Hamas, disseram eles, seria um “momento importante se as FDI estiverem utilizando a IA de uma forma significativa para fazer escolhas de alvos com consequências de vida ou morte”.

Soldados israelenses durante operações terrestres na Faixa de Gaza. – IDF

Soldados israelenses durante operações terrestres na Faixa de Gaza. – IDF

De 50 metas por ano para 100 por diaNo início de novembro, as FDI afirmaram que “mais de 12.000” alvos em Gaza tinham sido identificados pela sua divisão de administração de alvos.

Ao descrever o processo de seleção de alvos da unidade, um oficial disse: “Trabalhamos sem concessões na definição de quem e o que é o inimigo. Os agentes do Hamas não estão imunes – não importa onde se escondam.”

As atividades da divisão, formada em 2019 na diretoria de inteligência das IDF, são sigilosas.

No entanto, uma breve declaração no site das FDI afirmava que estavam usando um sistema baseado em IA chamado Habsora (o Evangelho, em inglês) na guerra contra o Hamas para “produzir alvos a um ritmo rápido”.

A IDF disse que “através da extração rápida e automática de inteligência”, o Evangelho produziu recomendações de direcionamento para seus pesquisadores “com o objetivo de uma correspondência completa entre a recomendação da máquina e a identificação realizada por uma pessoa”.

Múltiplas fontes familiarizadas com os processos de seleção de alvos das IDF confirmaram a existência do Evangelho para +972/Chamada Local, dizendo que ele foi usado para produzir recomendações automatizadas para atacar alvos, como casas particulares de indivíduos suspeitos de serem agentes do Hamas ou da Jihad Islâmica.

Nos últimos anos, a divisão alvo ajudou as FDI a construir um banco de dados do que fontes disseram ser entre 30.000 e 40.000 supostos militantes. Sistemas como o Evangelho, disseram eles, desempenharam um papel crítico na construção de listas de indivíduos autorizados a serem assassinados.

Aviv Kochavi, que serviu como chefe das FDI até janeiro, disse que a divisão alvo é “alimentada por capacidades de IA” e inclui centenas de oficiais e soldados.

Numa entrevista publicada antes da guerra , ele disse que era “uma máquina que produz grandes quantidades de dados de forma mais eficaz do que qualquer ser humano, e os traduz em alvos para ataque”.

De acordo com Kochavi, “uma vez ativada esta máquina” na guerra de 11 dias de Israel com o Hamas, em maio de 2021, gerou 100 alvos por dia. “Para colocar isso em perspectiva, no passado produzíamos 50 alvos em Gaza por ano. Agora, esta máquina produz 100 alvos por dia, sendo que 50% deles são atacados.”

Não se sabe exatamente quais formas de dados são ingeridas no Evangelho. Mas os especialistas afirmam que os sistemas de apoio à decisão baseados em IA para a seleção de alvos normalmente analisam grandes conjuntos de informações provenientes de diversas fontes, tais como imagens de drones, comunicações interceptadas, dados de vigilância e informações extraídas da monitorização dos movimentos e padrões de comportamento de indivíduos e grandes grupos.

A divisão de alvos foi criada para resolver um problema crônico das FDI: em operações anteriores em Gaza, a força aérea ficou repetidamente sem alvos para atacar. Como os altos funcionários do Hamas desapareciam nos túneis no início de qualquer nova ofensiva, disseram as fontes, sistemas como o Gospel permitiram às IDF localizar e atacar um grupo muito maior de agentes juniores.

Um funcionário, que trabalhou nas decisões de seleção de alvos em operações anteriores em Gaza, disse que as FDI não haviam anteriormente alvejado as casas de membros juniores do Hamas para bombardeios. Afirmaram acreditar que a situação tinha mudado no atual conflito, com as casas de supostos agentes do Hamas agora alvo de alvos independentemente da sua posição.

“São muitas casas”, disse o funcionário ao +972/Local Call. “Membros do Hamas que realmente não significam nada vivem em casas por toda Gaza. Então eles marcam a casa e bombardeiam a casa e matam todo mundo lá.”

Alvos recebem ‘pontuação’ para provável número de mortes de civis

Na breve declaração das FDI sobre a sua divisão-alvo, um alto funcionário disse que a unidade “produz ataques precisos à infraestrutura associada ao Hamas, ao mesmo tempo que inflige grandes danos ao inimigo e danos mínimos aos não-combatentes”.

A precisão dos ataques recomendados pelo “banco alvo de IA” foi enfatizada em vários relatórios na mídia israelense. O jornal diário Yedioth Ahronoth informou que a unidade “garante, tanto quanto possível, que não haja danos a civis não envolvidos”.

Uma antiga fonte militar israelita disse ao Guardian que os agentes utilizam uma medição “muito precisa” da taxa de civis que evacuam um edifício pouco antes de um ataque. “Usamos um algoritmo para avaliar quantos civis restam. Isso nos dá verde, amarelo, vermelho, como um sinal de trânsito.”

No entanto, especialistas em IA e conflitos armados que falaram com o Guardian disseram que estavam céticos em relação às afirmações de que os sistemas baseados em IA reduziam os danos aos civis, incentivando uma segmentação mais precisa.

Um advogado que aconselha governos sobre IA e cumprimento do direito humanitário disse que havia “poucas provas empíricas” para apoiar tais afirmações. Outros apontaram para o impacto visível do bombardeio.

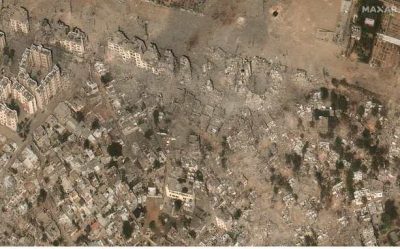

“Observe a paisagem física de Gaza”, disse Richard Moyes, pesquisador que dirige o Article 36, um grupo que faz campanha para reduzir os danos causados pelas armas.

“Estamos assistindo ao arrasamento generalizado de uma área urbana com armas explosivas pesadas, por isso afirmar que há precisão e estreiteza da força a ser exercida não é confirmado pelos fatos.”

Imagens de satélite da cidade de Beit Hanoun, no norte de Gaza, antes (10 de outubro) e depois (21 de outubro) dos danos causados pela guerra. – Maxar Technologies/Reuters

Imagens de satélite da cidade de Beit Hanoun, no norte de Gaza, antes (10 de outubro) e depois (21 de outubro) dos danos causados pela guerra. – Maxar Technologies/Reuters

De acordo com números divulgados pelas FDI em novembro, durante os primeiros 35 dias da guerra Israel atacou 15.000 alvos em Gaza, um número que é consideravelmente superior às operações militares anteriores no território costeiro densamente povoado. Em comparação, na guerra de 2014, que durou 51 dias, as FDI atingiram entre 5.000 e 6.000 alvos.

Várias fontes disseram ao Guardian e ao +972/Local Call que quando um ataque era autorizado nas casas privadas de indivíduos identificados como agentes do Hamas ou da Jihad Islâmica, os investigadores alvo sabiam antecipadamente o número de civis que se esperava serem mortos.

Cada alvo, disseram, tinha um arquivo contendo uma pontuação de danos colaterais que estipulava quantos civis provavelmente seriam mortos em um ataque.

Uma fonte que trabalhou até 2021 no planejamento de ataques para as FDI disse que “a decisão de atacar é tomada pelo comandante da unidade em serviço”, alguns dos quais estavam “mais satisfeitos com o gatilho do que outros”.

A fonte disse que houve ocasiões em que “houve dúvidas sobre um alvo” e “matamos o que considerei ser uma quantidade desproporcional de civis”.

Um porta-voz militar israelense disse: “Em resposta aos ataques bárbaros do Hamas, as FDI operam para desmantelar as capacidades militares e administrativas do Hamas. Em total contraste com os ataques intencionais do Hamas contra homens, mulheres e crianças israelitas, as FDI seguem o direito internacional e tomam precauções viáveis para mitigar os danos civis.”

‘Fábrica de assassinatos em massa’

Fontes familiarizadas com a forma como os sistemas baseados em IA foram integrados nas operações da IDF disseram que tais ferramentas aceleraram significativamente o processo de criação de alvos.

“Preparamos as metas automaticamente e trabalhamos de acordo com uma lista de verificação”, disse uma fonte que anteriormente trabalhou na divisão de metas ao +972/Local Call. “É realmente como uma fábrica. Trabalhamos com rapidez e não há tempo para nos aprofundarmos no alvo. A visão é que somos julgados de acordo com quantas metas conseguimos gerar.”

Uma fonte separada disse à publicação que o Evangelho permitiu que as FDI administrassem uma “fábrica de assassinatos em massa” na qual “a ênfase está na quantidade e não na qualidade”. Um olho humano, disseram eles, “passará pelos alvos antes de cada ataque, mas não precisará gastar muito tempo neles”.

Para alguns especialistas que investigam a IA e o direito humanitário internacional, uma aceleração deste tipo suscita uma série de preocupações.

Marta Bo, pesquisadora do Instituto Internacional de Pesquisa para a Paz de Estocolmo, disse que, mesmo quando “os humanos estão no circuito”, há o risco de desenvolverem “viés de automação” e “dependerem excessivamente de sistemas que passam a ter muita influência sobre decisões humanas complexas”.

Moyes, do Artigo 36, disse que ao confiar em ferramentas como o Evangelho, um comandante “recebe uma lista de alvos que um computador gerou” e eles “não necessariamente sabem como a lista foi criada ou têm a capacidade de interrogar e questionar adequadamente as recomendações de direcionamento”.

“Existe o perigo”, acrescentou ele, “de que, à medida que os humanos passem a confiar nestes sistemas, se tornem engrenagens de um processo mecanizado e percam a capacidade de considerar o risco de danos civis de uma forma significativa”.

Nenhum comentário ainda, seja o primeiro!