Tecnologia é capaz de levar uma percepção semelhante à do olho humano para as máquinas.

Com o rápido avanço da inteligência artificial, sistemas não tripulados, como direção autônoma e inteligência incorporada, estão sendo continuamente promovidos e aplicados em cenários do mundo real, levando a uma nova onda de revolução tecnológica e transformação industrial. A percepção visual, um meio central de aquisição de informações, desempenha um papel crucial nesses sistemas inteligentes. No entanto, alcançar uma percepção visual eficiente, precisa e robusta em ambientes dinâmicos, diversos e imprevisíveis permanece um desafio aberto.

Em cenários de mundo aberto, os sistemas inteligentes devem não apenas processar grandes quantidades de dados, mas também lidar com diversos eventos extremos, como perigos súbitos, mudanças drásticas no ambiente de luz nas entradas de túneis e forte interferência de flashes à noite em cenários de direção. Os chips de sensoriamento visual tradicionais, limitados pelas “barreiras de potência” e “barreiras de largura de banda”, frequentemente enfrentam problemas de distorção, falha ou alta latência ao lidar com esses cenários, impactando severamente a estabilidade e a segurança do sistema.

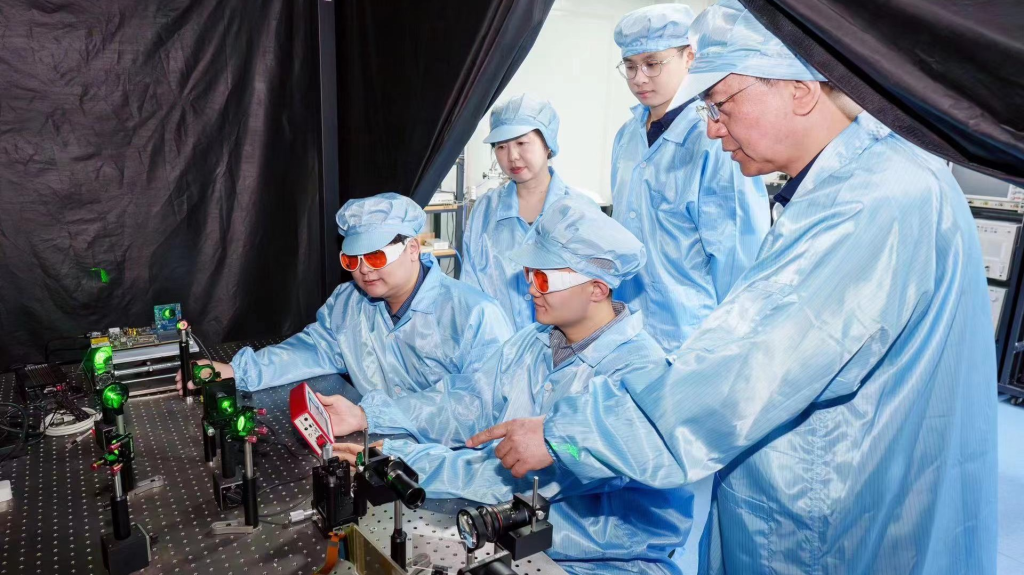

Para enfrentar esses desafios, o Centro de Pesquisa em Computação Inspirada no Cérebro (CBICR) da Universidade Tsinghua tem se concentrado em tecnologias de sensoriamento visual inspiradas no cérebro e propôs um paradigma de sensoriamento complementar inovador, compreendendo uma representação baseada em primitivas e dois caminhos visuais complementares. Inspirado pelos princípios fundamentais do sistema visual humano, essa abordagem decompõe as informações visuais em representações visuais baseadas em primitivas. Combinando essas primitivas, ela imita as características do sistema visual humano, formando dois caminhos de percepção visual complementares e completos em termos de informações.

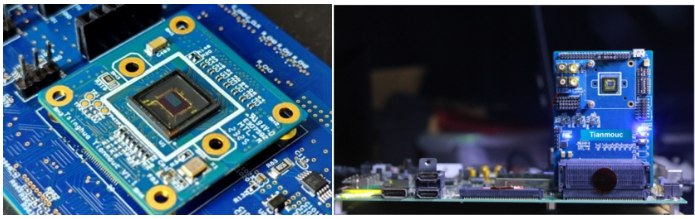

Com base nesse novo paradigma, o CBICR desenvolveu o primeiro chip de visão complementar inspirado no cérebro do mundo, o “Tianmouc”. Esse chip alcança aquisição de informações visuais em alta velocidade a 10.000 quadros por segundo, precisão de 10 bits e um alto alcance dinâmico de 130 dB, tudo isso reduzindo a largura de banda em 90% e mantendo baixo consumo de energia. Ele não apenas supera os gargalos de desempenho dos paradigmas tradicionais de sensoriamento visual, mas também lida eficientemente com diversos cenários extremos, garantindo a estabilidade e a segurança do sistema.

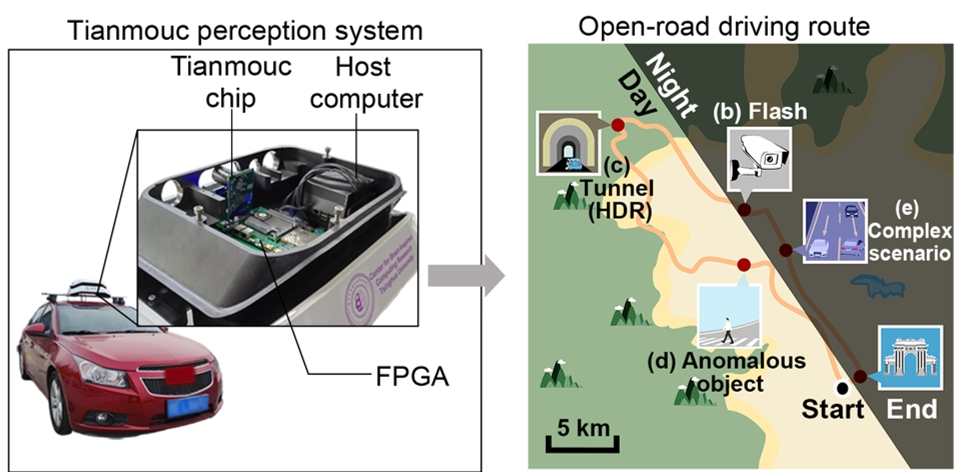

Aproveitando o chip Tianmouc, a equipe desenvolveu software e algoritmos de alto desempenho, e validou seu desempenho em uma plataforma de percepção montada em veículos operando em ambientes abertos. Em diversos cenários extremos, o sistema demonstrou percepção em tempo real de baixo atraso e alto desempenho, mostrando seu imenso potencial para aplicações no campo de sistemas inteligentes não tripulados.

O desenvolvimento bem-sucedido do Tianmouc é um avanço significativo no campo dos chips de sensoriamento visual. Ele não apenas fornece forte suporte tecnológico para o avanço da revolução inteligente, mas também abre novos caminhos para aplicações cruciais, como direção autônoma e inteligência incorporada. Combinado com a base tecnológica estabelecida do CBICR em chips de computação inspirados no cérebro, como o “Tianjic”, ferramentas e robótica inspirada no cérebro, a adição do Tianmouc irá fortalecer ainda mais o ecossistema de inteligência inspirada no cérebro, impulsionando poderosamente o progresso da inteligência artificial geral.

O artigo de pesquisa baseado nesses resultados, “Um Chip de Visão com Caminhos Complementares para Sensoriamento em Mundo Aberto,” foi destacado como artigo de capa da Nature na edição de 30 de maio de 2024. Esta é a segunda vez que a equipe é destaque na capa da Nature, após seu trabalho anterior no chip de computação inspirado no cérebro de paradigma híbrido “Tianjic.” Esse feito significa avanços fundamentais tanto na computação inspirada no cérebro quanto no sensoriamento inspirado no cérebro.

Os autores correspondentes são os Professores Luping Shi e Rong Zhao do Departamento de Instrumentos de Precisão da Universidade Tsinghua. Os co-primeiros autores são o Dr. Zheyu Yang (Ph.D. graduado pelo Departamento de Instrumentos de Precisão da Universidade Tsinghua; atualmente Gerente de Pesquisa e Desenvolvimento na Beijing Lynxi Technology Co., Ltd.), Taoyi Wang e Yihan Lin (candidatos a Ph.D. do Departamento de Instrumentos de Precisão da Universidade Tsinghua). A primeira afiliação é da Universidade Tsinghua, e as afiliações colaborativas incluem a Beijing Lynxi Technology Co., Ltd.

Nenhum comentário ainda, seja o primeiro!